Основы теоретической робототехники. Искусственные нейронные сети. (Обзор)

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

СОДЕРЖАНИЕ |

|

|

|

стр. |

|

Введение

::::..:::::::::::::::::::::::. |

3 |

|

1. Биологические предпосылки возникновения теории

искусственных нейронных сетей :::::::::::::::::::::::. |

4 |

|

2. Основные понятия и

однослойные нейронные сети...::..:::::: |

4 |

|

2.1. Искусственный нейрон и функция активации ..::::::........... |

4 |

|

2.2.

Однослойные нейронные сети и правила их обучения :::::: |

5 |

|

3. Многослойные нейронные

сети ::::::::::..::::::... |

9 |

|

3.1.

Алгоритм обратного распространения ошибки ::::::.::... |

9 |

|

4. Релаксационные нейронные сети::::::::::::::.......... |

11 |

|

4.1.

Нейронная сеть Хопфильда ..::::::..:::::::::: |

11 |

|

5. Самоорганизующиеся

нейронные сети Кохонена:::::::::... |

14 |

|

5.1.

Конкурентное обучение :::::::::::::::::...... |

14 |

|

5.2.

Самоорганизующиеся карты Кохонена ::::::::::::. |

15 |

|

Литература::::::::::::::::::::::::::: |

16 |

|

Рисунки

:::::::::::::::::::::::::::..... |

17 |

Введение

Система

искусственного интеллекта способна в зависимости от состояния входов, изменять

не только параметры функционирования, но и сам способ своего поведения, причём

способ поведения зависит не только от текущего состояния входов, но также от предыдущих состояний системы.

В

настоящее время искусственный интеллект (ИИ) сформировался уже ни как одно из направлений информационных

технологий, а как обширная область исследований и разработок интеллектуальных

систем, предназначенных для работы в трудно формализуемых областях

деятельности. Можно выделить следующие направления развития ИИ: разработка

интеллектуальных систем, основанных на знаниях, распознавание образов, игры и

творчество, компьютерная лингвистика, интеллектуальные роботы и т.д. Одна из

основных тем исследований в области ИИ является нейросетевые и нейрокомпьютерные

технологии. В основе этих исследований лежат искусственные нейронные сети (НС),

которые представляют собой математическую конструкцию, основным элементом

которой является искусственный нейрон [5-7].

Данная

работа продолжает линию, начатую [8].

При

составлении данного обзора активно использовались работы [1-7,9].

1. Биологические предпосылки возникновения теории

искусственных нейронных сетей

В

основе теории искусственных нейронных сетей лежит идея создания интеллектуального

устройства по образу и подобию человеческого мозга. Дело в том, что способ

обработки информации человеческим мозгом принципиально отличается от способов,

используемых в обычных - неймановских компьютерах. Основное преимущество биологического

мозга заключается в параллельности производимых им вычислений [5-7].

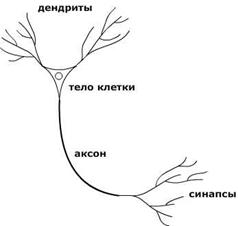

В

первом приближении, мозг человека состоит из нейронов и соединяющих их волокон. Каждый нейрон состоит из тела клетки,

дендритов и аксонов, и, обладающей электрической активностью. Упрощённо принцип

действия нейрона выглядит следующим образом: через дендриты нейрон получает нервные импульсы от других нейронов; в теле нейрона сигнал обрабатывается;

обработанный сигнал, через аксон,

разветвляющийся на конце на множество нервных нитей - синапсы, передаётся дальше, к другим нейронам. На рис. 1

представлена схема биологического нейрона. Простейший нейрон может иметь

порядка 103:104 дендритов, т.е. быть связанным с 10000

других нейронов. Всего в человеческом мозге приблизительно 1011 нейронов.

Следует

отметить, что биологически мозг обладает способностью организовывать нейроны и

связи между ними так, что они выполняют такие задачи как распознавание образов,

обработку сигналов органов чувств, моторные функции и т.д. во много раз быстрее

чем, это делают самые современные компьютеры, так как хотя скорость распространения

нервного импульса в аксоне приблизительно 100 м/с, что в миллион раз меньше,

чем скорость передачи электрического сигнала, однако за счёт огромного

количества соединений между нейронами, т.е. за счёт параллельной обработки

информации, человеческий мозг мгновенно

справляется с задачам, для решения которых "обычным" компьютерам требуются

несравнимо большее время.

2. Основные понятия и однослойные нейронные сети

2.1.

Искусственный нейрон и Функция активации

Как

говорилось ранее искусственная нейронная сеть (НС), это математическая модель,

основной частью которой является искусственный нейрон, осуществляющий нелинейное

преобразование F суммы произведения входных сигналов на

весовые коэффициенты(рис. 2):

![]() ,

,

где

![]() - вектор весовых коэффициентов,

- вектор весовых коэффициентов, ![]() - вектор входных сигналов,

- вектор входных сигналов,

![]() - взвешенная сумма, F

- оператор нелинейного преобразования или функция

активации. Взвешенную сумму

- взвешенная сумма, F

- оператор нелинейного преобразования или функция

активации. Взвешенную сумму ![]() иногда представляют в

виде

иногда представляют в

виде ![]() , где

, где ![]() - порог нейронного элемента, характеризующий сдвиг функции

активации по оси абсцисс. Если продолжить биологические аналогии, то входы xi

являются для искусственного нейрона дендритами, операторы суммирования и

нелинейного преобразования - телом нейрона, а выход y - аксоном.

- порог нейронного элемента, характеризующий сдвиг функции

активации по оси абсцисс. Если продолжить биологические аналогии, то входы xi

являются для искусственного нейрона дендритами, операторы суммирования и

нелинейного преобразования - телом нейрона, а выход y - аксоном.

В качестве оператора нелинейного

преобразования могут выступать различные функции, которые выбираются в соответствии

с рассматриваемой задачей и типом НС. Рассмотрим наиболее часто используемые

функции активации.

- Линейная функция:

![]() .

.

- Пороговая функция:

![]() или

или ![]()

- Сигмоидная функция: ![]() , где

, где ![]() - коэффициент, определяющий ширины функции по оси абсцисс.

- коэффициент, определяющий ширины функции по оси абсцисс.

Следует

отметить, что в силу монотонности и всюду дифференцируемости сигмоидная функция

является наиболее распространённой. Её график приведён на рис.3.

2.2. Однослойные

нейронные сети и правила их обучения

В

многослойной НС нейроны располагаются по слоям. В простейшем случае в такой

сети существует входной слой,

информация от которого передаётся на выходной

слой. Такая сеть называется однослойной.

Её топология представлена на рис. 4. Так как в таких сетях сигналы передаются в

одном направлении, они получили названия сети

прямого распространения.

Как

видно из рисунка, каждый вход ![]() соединён с каждым

нейроном единственного слоя НС. Выход j-го

нейронного элемента вычисляется по формуле:

соединён с каждым

нейроном единственного слоя НС. Выход j-го

нейронного элемента вычисляется по формуле:

![]() ,

,

где

![]() - весовой коэффициент между i-ым

входом и

j-ым нейроном. Таким образом весовые

коэффициента НС можно представить в виде матрицы размерностью

- весовой коэффициент между i-ым

входом и

j-ым нейроном. Таким образом весовые

коэффициента НС можно представить в виде матрицы размерностью ![]() , где

, где ![]() - количество вход НС,

- количество вход НС, ![]() - количество нейронных элементов:

- количество нейронных элементов:

.

.

Одной

из основных задач при использовании нейронных сетей является подбор весовых

коэффициентов, для решения рассматриваемой задачи. Для этой цели существуют правила обучения нейронных сетей,

которые определяют как изменяются значение весовых коэффициентов в зависимости

от входных сигналов. Рассмотрим правила обучения однослойных нейронных сетей.

1. Правило обучения Хебба.

Обучение

методом Хебба является самым известным среди всех правил обучения. Оно

основывается на биологической предпосылке о том, что если два нейрона при

подаче сигнала активизируются одновременно, "прочность" этого соединения

возрастает. Математически правило обучения Хебба записывается следующим

образом:

![]()

где

![]() - номер итерации.

- номер итерации.

В

качестве примера рассмотрим решение двухмерной логической задачи "И" при помощи

процедуры обучения Хебба. Для решения используется простейшая НС состоящая из 2

нейронов входного слоя и 1 нейрона выходного слоя (рис. 5). Как видно из рисунка

порог нейронного элемента можно вынести в качестве отдельного входа с весовым

коэффициентом равным ![]() и входным сигналом -1.

Для данной сети взвешенная сумма равна:

и входным сигналом -1.

Для данной сети взвешенная сумма равна:

![]() ,

,

а

правило Хебба запишется в виде следующей системы:

Рассмотрим

решение данной задачи методом обучения с учителем, т.е. в качестве выходных

значений НС будем использовать эталонные значения. Остальные параметры НС выглядят

следующим образом:

- биполярная

кодировка входных сигналов;

- функции

активации: биполярная пороговая функция  .

.

Имеем

следующую обучающую выборку:

|

|

|

|

|

-1 |

-1 |

-1 |

|

1 |

-1 |

-1 |

|

-1 |

1 |

-1 |

|

1 |

1 |

1 |

Итак

рассмотрим процесс обучения:

|

|

|

|

|

|

|

|

|

Обучение

прекращается при подаче на вход НС всех входных образов. В итоге, мы обучили НС

(подобрали весовые коэффициенты) решать задачу логического "И".

2. Персептрон Розенблатта.

Персептроном

Розенблатта называется нейронная сеть, состоящая из двух слоёв. Первый слой

нейронов этой НС называется сенсорным и выполняет исключительно распределительную

функцию входных сигналов. Второй слой называется ассоциативным. Нейронные элементы

в нём имеют пороговую функцию активации и именно они производят

непосредственную обработку информации.

Процедура

обучения персептрона выглядит следующим образом:

![]()

где

![]() - эталонное значение j-го

выхода НС,

- эталонное значение j-го

выхода НС, ![]() - скорость обучения сети (

- скорость обучения сети (![]() ).

).

Таким

образом, процедура обучение Розенблатта, это во-первых, обучение с учителем

(имеем эталонные значения выходов), а во-вторых, обучение с подкреплением

(весовые коэффициенты нейронного элемента изменяются только в том случае, если

выходное значение этого элемента отличается от эталонного).

Следует отметить, что персептрон

Розенблатта способен решать задачи логического "И" и логического "ИЛИ", но не

может решить задачу "ИСКЛЮЧАЮЩЕЕ ИЛИ". В связи с этим, в 1969 г. М.Минский и

С.Пайперт в своей работе "Персептроны: введение в вычислительную геометрию"

сделали довольно пессимистичные выводы по поводу дальнейшего развития нейронных

сетей, что привело к приостановке исследований в этой области практически на 20

лет.

3. Правило обучения Видроу-Хоффа

Данное

правило используется для обучении НС в выходном слое которых, расположен один

нейрон с линейной функцией активации (рис. 6). Такая НС называется ADALINE (ADAptive LINer Element). Правило основано на

минимизации среднеквадратичной ошибки НС, которая определяется по следующей формуле:

![]() ,

,

где

![]() - размерность обучающей выборки,

- размерность обучающей выборки, ![]() - выход НС, для m-го

входного образа,

- выход НС, для m-го

входного образа, ![]() - эталонное значение для m-го

входного образа. Величина

- эталонное значение для m-го

входного образа. Величина ![]() является среднеквадратичной

ошибкой НС для m-го входного образа.

является среднеквадратичной

ошибкой НС для m-го входного образа.

Обучение

основано на методе градиентного спуска в пространстве порогов и весовых

коэффициентов:

![]() ;

;

![]()

где

![]() , n - размерность входного сигнала,

, n - размерность входного сигнала, ![]() - скорость обучения.

- скорость обучения.

После

приведения формулы запишутся следующим образом:

![]() ;

;

![]()

где

![]() ,

, ![]() - j-ая компонента образа m.

- j-ая компонента образа m.

Схема

алгоритма обучения по правилу Видроу-Хоффа выглядит следующим образом:

Шаг 1. Задаются

скорость обучения ![]() и минимальная среднеквадратичная

ошибка сети

и минимальная среднеквадратичная

ошибка сети ![]() ;

;

Шаг 2. Случайным

образом инициализируются весовые коэффициенты -![]() и порог -

и порог - ![]() ;

;

Шаг 3. На вход НС

поочерёдно подаются все L входных образов. Для каждого образа вычисляется его

среднеквадратичная ошибка.

Шаг 4. Вычисляется

среднеквадратичная ошибка всей НС - ![]() . Если

. Если ![]() , то сеть считается обученной, иначе к 5.

, то сеть считается обученной, иначе к 5.

Шаг 5. По приведённым

выше формулам модифицируются весовые коэффициенты и порог нейрона.

Следует

отметить, что если скорость обучение ![]() выбрать слишком маленькой, то процесс сходимости будет очень

долгим, если же его выбрать слишком большим, то в процессе решения можно

"проскочить" минимум среднеквадратичной ошибки. Решение этой проблемы возможно

с помощью адаптивного шага обучения. В литературе [1] предлагается следующее

выражение:

выбрать слишком маленькой, то процесс сходимости будет очень

долгим, если же его выбрать слишком большим, то в процессе решения можно

"проскочить" минимум среднеквадратичной ошибки. Решение этой проблемы возможно

с помощью адаптивного шага обучения. В литературе [1] предлагается следующее

выражение:

.

.

Правило

Вудроу-Хоффа носит также название дельта-правило.

До сих пор речь шла о НС, содержащих

один распределительный (входной) слой и один выходной слой, в котором

происходила обработка информации. Если обрабатывающих информацию слоёв два или

больше, то такая НС называется многослойной.

3. Многослойные нейронные сети

Топология многослойной НС представлена на рисунке 7. В

качестве функций активации во всех нейронных элементах обычно используется сигмоидная

функция, так как она, как говорилось ранее, является монотонной и всюду

дифференцируемой. Для обучения многослойных НС используется алгоритм обратного

распространения ошибки, о котором речь пойдёт ниже. Следует отметить, что в

основе использования этого типа НС лежит теорема А.Н. Колмогорова: любую непрерывную функцию n переменных на единичном отрезке ![]() можно представить в

виде суммы конечного числа одномерных функций:

можно представить в

виде суммы конечного числа одномерных функций:

![]() ,

,

где функции ![]() и

и ![]() являются одномерными и

непрерывными,

являются одномерными и

непрерывными,![]() для всех i.

для всех i.

Обобщая эту теорему на

многослойные нейронные сети, можно сформулировать следующее утверждение [1,4]:

Любая непрерывная функция ![]() может быть аппроксимирована

с любой степень точности трёхслойной нейронной сетью с одним скрытым слоем,

весовые коэффициенты которой, настроены с помощью алгоритма обратного

распространения ошибки.

может быть аппроксимирована

с любой степень точности трёхслойной нейронной сетью с одним скрытым слоем,

весовые коэффициенты которой, настроены с помощью алгоритма обратного

распространения ошибки.

В связи с появлением как

минимум ещё одного слоя, введённые ранее величины изменяться:

![]() , где

, где ![]() - выход j-го нейронного элемента

выходного слоя,

- выход j-го нейронного элемента

выходного слоя, ![]() - взвешенная сумма j-го нейронного элемента;

- взвешенная сумма j-го нейронного элемента;

![]() , где

, где ![]() - весовой коэффициент связи идущей от i-го нейронного элемента

скрытого слоя к j-у нейронному элементу

выходного слоя,

- весовой коэффициент связи идущей от i-го нейронного элемента

скрытого слоя к j-у нейронному элементу

выходного слоя, ![]() - порог j-го

нейронного элемента выходного слоя.

- порог j-го

нейронного элемента выходного слоя.

3.1. Алгоритм обратного распространения ошибки

Алгоритм

обратного распространения ошибки используется для обучения многослойных

нейронных сетей. Как и правило Вудроу-Хоффа (дельта-правило) данный алгоритм

минимизирует среднеквадратичную ошибку НС, используя для этого метод

градиентного спуск в пространстве порогов и весовых коэффициентов. В процессе

работы алгоритма можно выделить две фазы: фаза

прямого распространения входного сигнала (входной образ подаётся на вход сети

и вычисляется выходная активность НС) и фаза

обратного распространения сигнала (по сети, в обратном направлении распространяется

ошибка - отклонение полученного выхода от эталонного значения для данного

входного образа).

Не вдаваясь в

математические выкладки [1-4] сразу приведём схему алгоритма обратного

распространения ошибки.

Шаг

1. Задаются скорость обучения ![]() и минимальная среднеквадратичная

ошибка сети

и минимальная среднеквадратичная

ошибка сети ![]() ;

;

Шаг

2. Случайным образом инициализируются весовые

коэффициенты -![]() и пороги -

и пороги - ![]() ;

;

Шаг

3. На вход НС поочерёдно подаются все L

входных образов из обучающей выборки. Для каждого образа выполняются следующие

операции:

-

фаза

прямого распространения сигнала, на которой вычисляется

выходная активность всех слоёв НС:

![]() ,

,

где индекс j

обозначает нейронные элементы, расположенные в

слое, следующем за

слоем i;

-

фаза

обратного распространении сигнала, на которой вычисляется

ошибка каждого из слоёв:

ошибка выходного слоя НС:

![]() ,

,

где ![]() - ошибка j-го

нейронного элемента выходного слоя,

- ошибка j-го

нейронного элемента выходного слоя,

![]() - выходное

значение j-го нейронного элемента выходного слоя,

- выходное

значение j-го нейронного элемента выходного слоя,

![]() - эталонное

значение j-го нейронного элемента выходного слоя;

- эталонное

значение j-го нейронного элемента выходного слоя;

ошибка

всех остальных слоёв НС:  ,

,

где индекс i означает

следующий слой по отношение слою j.

Шаг 4. Модифицируются весовые коэффициенты и пороги НС:

Шаг 5. Вычисляется среднеквадратичная ошибка сети:

![]()

где

![]() - размерность

обучающей выборки.

- размерность

обучающей выборки.

Шаг 6. Если ![]() , то обратно к шагу 3, иначе НС считается обученной.

, то обратно к шагу 3, иначе НС считается обученной.

Следует отметить, что алгоритм обратного распространения

ошибки обладает некоторыми недостатками. В следующей таблице даны способы их преодоления.

|

Недостаток |

Способ

решения |

|

Проблема инициализации весовых коэффициентов: разная инициализация может привести к различным

решениям задачи. |

Инициализировать весовые

коэффициенты значениями следующего порядка: -

-

-

|

|

Проблема топологии НС: при слишком большой размерности скрытого слоя

может наступить эффект перетренированности. |

Размерность скрытого слоя

должна быть меньше размерности обучающей выборки. |

|

"Застревание" решения в локальных минимумах

пространства порогов и весовых коэффициентов |

Изменение весовых

коэффициентов по формуле:

где |

|

Проблема выбора скорости обучения: при слишком маленькой

скорости, процесс обучения может быть неоправданно долгим, при слишком большой,

есть опасность "проскочить" решение. |

Адаптивный шаг обучения |

4. Релаксационные нейронные сети

Релаксационные

сети - это сети, в которых

распространение сигнала происходит как в прямом, так и в обратном направлении.

На каждом такте работы НС один или несколько нейронных элементов обрабатывают

информацию, полученную на предыдущем шаге, т.е. функционирование релаксационных

НС носит итеративный характер. Такая обработка информации происходит до тех пор

пока все нейронные элементы не перейдут состояние равновесия. При этом

состояния нейронных элементов перестаёт изменяться. Мы будем рассматривать

релаксационные НС на примере сети Хопфилда [1,4].

4.1. Нейронная сеть Хопфилда

Архитектура

НС Хопфилда представлена на рис. 8. Первый слой называется распределительным,

второй - вычислительным. Выход НС в момент времени t+1 вычисляется следующим образом:

Так

как в данной сети все нейронные элементы соединены друг с другом, то матрица

весовых коэффициентов является симметричной с нулями на главной диагонали:

НС Хопфилда представляет собой динамическую систему,

состояния которой характеризуется фазовым пространством. Функционирование сети

можно представить как движение в этом пространстве к точке равновесия. Проведя

биологическую аналогию, можно определить данный процесс, как процесс вспоминания

информации.

Сеть Хопфилда с дискетным временем и пороговой

функцией активации называется сетью с

дискретным состоянием и временем; с непрерывной функцией активации - сетью

с непрерывным состоянием и дискретным временем; с непрерывным временем - непрерывной сетью. Также выделяют сети с

последовательной и параллельной динамикой. В случае с последовательной динамикой

в каждый момент времени функционирует только один нейронный элемент с номером k, который

выбирается случайным образом, при параллельной - своё состояние изменяют сразу

все нейроны сети.

|

Последовательная динамика |

Параллельная динамика |

|

|

|

Одно из основных свойств сети Хопфилда

это способность рспозновать зашумлённые сигналы. Представим входные образы,

которые необходимо запомнить в виде матрицы:

.

.

На практике обычно используют пороговую функцию активации,

бинарные входные векторы и нулевые пороги нейронных элементов. В этом случае

матрица весовых коэффициентов представим в виде:

![]() .

.

Алгоритма функционирования НС

Хопфилда выглядит следующим образом:

1.

Используя образы,

которые необходимо запомнить, вычисляется матрица весовых коэффициентов W.

2.

На вход сети

подаётся зашумлённый образ.

3.

До тех пор пока ![]() вычисляются состояния

нейронных элементов.

вычисляются состояния

нейронных элементов.

-

при

последовательной динамике:

Нейронный

элемент k выбирается случайным образом;

-

при параллельной

динамике:

.

.

Равенство

![]() означает, что сеть

пришла в установившееся состояние и

означает, что сеть

пришла в установившееся состояние и ![]() и есть распознанный

образ.

и есть распознанный

образ.

Приведём

пример. Пусть необходимо, что бы сеть запомнила следующий образ: ![]() . НС Хопфилда будет состоять из четырёх соединённых друг с

другом нейронных элементов (рис. 9). Матрица весовых коэффициентов примет вид:

. НС Хопфилда будет состоять из четырёх соединённых друг с

другом нейронных элементов (рис. 9). Матрица весовых коэффициентов примет вид:

Пусть

теперь на вход подаётся зашумлённый образ: ![]() . Рассмотрим алгоритм функционирования сети при параллельной

динамике. Так как мы используем пороговую функцию активации, то

. Рассмотрим алгоритм функционирования сети при параллельной

динамике. Так как мы используем пороговую функцию активации, то ![]() .

.

Как можно заметить состояние НС перестало

изменяться, т.е. сеть за одну итерацию пришла в устойчивое положение и

распознала зашумлённый образ.

5.

Самоорганизующиеся нейронные сети Кохонена

В предыдущих разделах речь шла о нейронных сетях, которые

перед началом работы необходимо было обучить, т.е. найти "правильные" пороги и

весовые коэффициенты. Однако, существует тип сетей, которые не нуждаются в

предварительном обучении. Такие сети, называемые самоорганизующимися, подстраивают свои весовые коэффициенты

непосредственно о время работы. На практике наибольшее распространения получили

сети Кохонена. В общем случае они представляют собой двухслойную нейронную

сеть, разбивающие входной n-мерное пространство на m областей (кластеров),

каждой из которой соответствует один нейронный элемент, т.е. НС Кохонена

состоит из n нейронов входного слоя и m нейронов выходного слоя. В качестве процедуры обучения

используется метод, получивший название конкурентное

обучение.

5.1.

Конкурентное обучение

Нейронные

сети, обучение которых происходит по методу конкурентного обучения, называются конкурентными. Как было сказано выше,

конкурентная НС представляет собой двухслойную сеть прямого распространения

сигнала. Процедура обучения выглядит следующим образом:

Шаг 1. Случайным образом инициализируются весовые коэффициенты НС - ![]() .

.

Шаг 2. Задаётся начальное значение номера

итерации - ![]() .

.

Шаг 3. На вход НС поочерёдно подаются все ![]() входных

образов. Для каждого образа выполняются следующие операции:

входных

образов. Для каждого образа выполняются следующие операции:

- определяется номер k нейрона-победителя, для

которого ![]() ,

,

- рассчитывается активность выходных нейронов: ![]()

- изменяются весовые коэффициенты нейрона-победителя по следующему

правилу: ![]() где параметр

где параметр ![]() называется скоростью

обучения.

называется скоростью

обучения.

Шаг 4. Увеличивается

номер итерации - ![]() ;

;

Шаг 5. Процедура обучения повторяется с

шага 3 до тех пор пока не будет получена необходимая степень кластеризации или

не перестанут изменяться весовые коэффициенты.

В некоторых источниках

советуют уменьшать скорость обучения с течением времени, например, по закону ![]() [1]. Также следует отметить, что для правильного определения

нейрона-победителя рекомендуют нормировать как входные образы, так и векторы

весовых коэффициентов.

[1]. Также следует отметить, что для правильного определения

нейрона-победителя рекомендуют нормировать как входные образы, так и векторы

весовых коэффициентов.

На практике иногда изменяют

весовые коэффициенты не только у нейрона-победителя но и у соседних нейронов. В

случае использования этой схемы, формула модификации весовых коэффициентов

примет следующий вид: ![]() где V множество нейронов, весовые

коэффициенты которых необходимо изменять, т.е. множество соседей

нейрона-победителя.

где V множество нейронов, весовые

коэффициенты которых необходимо изменять, т.е. множество соседей

нейрона-победителя.

Если изменить топология

конкурентной НС таким образом, что нейроны

выходного слоя будут расположены на плоскости, то мы получим самоорганизующуюся карту Кохонена.

5.2.

Самоорганизующиеся карты Кохонена

Топология

самоорганизующейся карты Кохонена представлена на рис. 10. Данная НС состоит из

нейронов входного слоя, выполняющих распределительную функцию, и вычислительного

слоя, нейроны которого располагаются на плоскости - слой Кохонена. Цель

функционирования сети выполнить топологическое упорядочивание входных сигналов,

т.е. "соседним" входным образам соответствуют соседние нейронные элементы

вычислительного слоя. Для решения этой задачи вводят область притяжения нейрона-победителя, таким образом, что все

нейроны, попадающие в эту область изменяют свои весовые коэффициенты и как бы

"притягиваются" к нейрону-победителю. Область притяжения можно задать в с

помощью функции притяжения ![]() , где t - время, k - номер

нейрона победителя и p - номера текущего нейрона. На

практике, в качестве функции h обычно используют функцию Гаусса:

, где t - время, k - номер

нейрона победителя и p - номера текущего нейрона. На

практике, в качестве функции h обычно используют функцию Гаусса:

![]()

где ![]() - нейрон-победитель с

номером k и координатами

- нейрон-победитель с

номером k и координатами ![]() в матрице выходного

слоя сети (нейроны выходного слоя лежат в плоскости, образуя матрицу);

в матрице выходного

слоя сети (нейроны выходного слоя лежат в плоскости, образуя матрицу); ![]() - текущий нейрон с

номером p и координатами

- текущий нейрон с

номером p и координатами ![]() в матрице выходного

слоя сети;

в матрице выходного

слоя сети; ![]() - расстояние между нейроном-победителем k и текущим нейроном p;

- расстояние между нейроном-победителем k и текущим нейроном p; ![]() - характеризует радиус

области притяжения и является убывающей функцией времени, т.е. радиус области

притяжения со временем уменьшается. Таким образом, в какой-то момент времени,

область притяжения "сожмётся" до одного нейрона-победителя и весовые

коэффициенты будут изменять только у него.

- характеризует радиус

области притяжения и является убывающей функцией времени, т.е. радиус области

притяжения со временем уменьшается. Таким образом, в какой-то момент времени,

область притяжения "сожмётся" до одного нейрона-победителя и весовые

коэффициенты будут изменять только у него.

Далее

представлен алгоритм обучения самоорганизующихся сетей. Пусть n - размерность входных образов и мы хотим разделить все

L входных образов на M кластеров. Тогда самоорганизующаяся карта Кохонена

имеет n распределительных нейронов и M нейронов в вычислительном слое. Представим эти M нейронов в виде матрицы размерностью ![]() , тогда

каждый нейрон вычислительного слоя имеет координаты

, тогда

каждый нейрон вычислительного слоя имеет координаты ![]() , где

, где ![]() , а вектор весовых коэффициентов нейрона с координатами

, а вектор весовых коэффициентов нейрона с координатами ![]() запишется в виде:

запишется в виде: ![]() . Для такой НС процедура обучения будет выглядеть следующим

образом:

. Для такой НС процедура обучения будет выглядеть следующим

образом:

Шаг 1. Случайным

образом инициализируются весовые коэффициенты - W.

Шаг 2. Номер

итерации (время) устанавливается t=1, задают

функцию ![]() и определяют начальное

значение радиуса притяжения -

и определяют начальное

значение радиуса притяжения - ![]() .

.

Шаг 3. Для всех ![]() входных образов выполняются следующие операции:

входных образов выполняются следующие операции:

-

вычисляется

норма вектор ![]() , где

, где ![]() ;

;

-

определяется

номер и координаты нейрона-победителя: ![]() где нейрон победитель

имеет номер k и координаты

где нейрон победитель

имеет номер k и координаты ![]() ;

;

-

для каждого

нейрона вычисляется функция притяжения: ![]() ;

;

-

выполняется модификация

весовых коэффициентов по следующему правила: ![]() , где

, где ![]() - характеризует скорость обучения и может быть либо

постоянной, либо уменьшаться с течением времени, например по закону

- характеризует скорость обучения и может быть либо

постоянной, либо уменьшаться с течением времени, например по закону ![]() .

.

Шаг 4. Увеличивается номер итерации

- ![]() и вычисляется новое

значение радиуса притяжения - функции

и вычисляется новое

значение радиуса притяжения - функции ![]() ;

;

Шаг 5. Процедура обучения

повторяется с шага 3 до тех пор, пока не будет получена необходимая степень

кластеризации, или не перестанут изменяться весовые коэффициенты.

Методология применения

самоорганизующихся карт Кохонена выглядит следующим образом:

1. Тренируют сеть на обучающей

выборки. Так как размерность входных образов n, то довольно часто в один кластер попадают образы, которые "с первого

взгляда" мало похожи.

2. На "обученную" сеть подают новый образ, определяют

нейрон-победитель и выявляют кластер, соответствующий этому нейрону. Таким

образом, делают вывод, что новый образ обладает свойствами, присущими всем

образам, попавших в данный кластер.

ЛИТЕРАТУРА

1. Головко В.А. Нейронные сети:

обучение, организация и применение. Кн.4: Учеб. пособие для вузов /Общая ред.

А.И.Галушкина.-М.:ИПРЖР,2001.-256с.:ил.

2. Хайкин С. Нейронные сети:

полный курс, 2-е издание.: Пер. с англ. - М.: Издательский дом "Вильямс", 2006.

- 1104 с.: ил.

3. Каллан Р. Основные концепции

нейронных сетей.: Пер. с англ. -М.: Издательский дом "Вильямс", 2001.287-с.:ил.

4. Круглов В.В., Борисов В.В.

Искусственные нейронные сети. Теория и практика. - М.: Горячая линия - Телеком,

2001. - 382 с.: ил:

5. Смолин Д.В. Введение в

искусственный интеллект. - М.: ФИЗМАТЛИ, 2004. - 208 с.

6. Ясницкий Л.Н. Введение в

искусственный интеллект. - М.: Издательский центр "Академия", 2005. - 176 с.

7. Э. Хант. Искусственный

интеллект. М.: Мир, 1978 - 560 с.

8. Петрин А.А. Основы

теоретической робототехники. Нечёткие методы. (Обзор).//М.:Препринт ИПМ им.

М.В.Келдыш РАН, 2005, №34, 23 с.

9. Голубев Ю.Ф. Нейросетевые методы в мехатронике. //М.:МГУ, 2007, 157

с.

РИСУНКИ

Рис. 1. Схема биологического нейрона.

Рис. 2. Схема искусственного нейрона.

Рис. 3. Сигмоидная функция активации (c=2).

Рис. 4. Однослойная нейронная сеть прямого

распространения.

Рис. 5. Нейронная сеть, состоящая из 2 нейронов

входного слоя и 1 нейрона

выходного слоя (с порогом).

Рис. 6. ADALINE (ADAptive LINear Element).

Рис. 7. Топология многослойной нейронной сети.

Рис. 8. Архитектура нейронной сети Хопфилда.

Рис. 9. Сеть Хопфилда, состоящая из четырёх

нейронных элементов

(z-1

- оператор единичной задержки).

Рис. 10. Топология самоорганизующейся карты Кохонена.